人工智能是一门既古老又崭新的学科。早期的人工智能为早期的工业和互联网发展做出了巨大的贡献。但是,早期人工智能技术对大脑的认识尚很肤浅;近年来,伴随脑科学的发展,人工智能正在进入一个新时代。其中最为突出的是深度学习(Deep Learning)研究。发明者借用了大脑的多层结构这一基本思想,通过对传统的人工神经网络改造,在诸如图像识别、语音识别等感知识别问题上已经取得了重大突破。

随着深度学习在应用领域获得的成功,相关研究日益得到广泛的支持和关注。但是,由于对深度学习的核心基础、特点和功能的理解不够全面深入,相当数量的媒体报道和大众认知对深度学习、特别是对深度学习与脑科学的关系,在认识上产生了一些想象与偏见:一方面,某些注重应用的人士认为,深度学习是人工智能技术的核心,与脑科学关系不大,因此深度学习研究不用关注脑科学发展;而另一方面,某些注重社会发展的人士则认为,类人脑的人工智能时代已经到来并威胁到人类的生存。应该说,这两种理解都比较片面、各有偏差。然而由于目前国内脑科学工作者专门探讨深度学习的论文相对较少,一些观念未能及时讨论和廓清,因此媒体对新一代人工智能技术的报道仍有不少误区。

针对上述情形,本文拟在以下方面进行努力:一,从深度学习的发展历史、理论核心和计算特征等方面,阐明深度学习和脑科学之间的密切关系。二,分析深度学习的功能、局限及导致局限的核心原因。其应用局限表明,深度学习作为一种弱人工智能,远未发展到威胁人类生存的程度;而导致其功能局限的核心原因则在于其神经模型的不完善。三,从神经模型、计算特征、功能及可行性等方面将深度学习和仿脑计算进行深入比较,指出仿脑计算在类人脑的新人工智能发展领域的巨大优势和发展前景。

(一)深度学习和脑科学的关系

关于深度学习和脑科学之间的深刻渊源和密切关系,笔者认为,如果说深度学习是人工智能技术的核心,那么脑科学中的仿脑计算将是深度学习的核心基础,而脑科学则是基础的基础。事实上,从技术发展和核心特征来看,深度学习的成功得益于脑科学发展所带来的启示,深度学习的两大特点也都来自于对大脑的模仿。

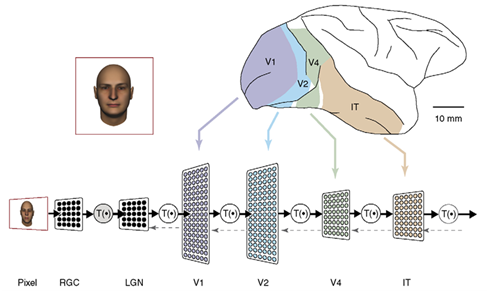

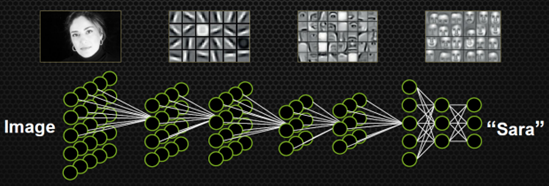

一是深度学习的神经网络结构特征。深度学习的成功是相对于传统人工神经网络的局限而言的。早期的人工神经网络发展比脑科学发展要早几乎半个世纪,因此,传统人工神经网络中的神经元、突触模型以及网络的构架和真实大脑相比都是极其粗糙而不准确的。深度学习相比传统的人工神经网络在构架上有了很大的变化。例如Google Net的层数高达22层。人的视网膜粗分有3层,如果细一点可以有5层甚至更多。大脑皮层至少有6层。从视网膜到具有识别功能的大脑IT区域,至少需要经过视网膜-LGN-V1-V2-V4-IT等6个区域,因此至少需要30多层,然而传统的神经网络常常只有2、3层。因此,深度学习首先在结构上打破了传统神经网络的传统,向大脑的结构靠近了一大步。值得指出的是,伴随结构深度的增加,神经元和连接的数量也大幅提升,对计算的要求也相应提高。近年来GPU的发展正好满足了深度学习的需求,为深度学习提供了良好的硬件基础。

深度神经网络的另一核心特征是卷积计算。而在神经网络中采用卷积计算则是受到大脑视觉系统中感受野(神经细胞所能感受到的空间区域)特征的启示。传统的神经网络在初始化时,常常是采用完全的连接,有大量的权重参数。在大脑中如果采用完全链接的话,大脑的空间也许要长得像地球那么大才能容得下那么多的连接线。显然,大脑通过演化达到了一定的优化,使神经元的数量和连接的数量比保持在一个合理的范围。深度学习中的卷积计算就是充分利用了这个特点,大大减少了需要调整的权重参数的个数。因此,可以说,目前深度学习的两大特点都来自于对大脑的模仿。

(二)深度学习的局限及其原因分析

从功能上看,目前深度学习的应用集中于人工智能中的模式识别,如图象识别、语音识别等。但是,在人脑中,识别功能仅仅是整个大脑功能的一小部分,而且还不是核心部分,因为许多低级动物也具有良好的视觉和听觉的感知与识别功能。人脑的核心功能在于学习与运用。在学习方面,大脑可以对具体事物进行全方位的学习,并具有概念抽象的能力。在运用方面,大脑可以举一反三、创造性地解决问题。以人类大脑的核心功能为参照来看,目前深度学习仅仅能对特定条件下的信息进行处理,达到特定的目的,因此,认为深度学习带来的新人工智能时代已经到来并威胁到我们人类的生存这一观点大可不必。在有关文章里,我们也常常看到从事深度学习研究的学者们多次表示深度学习不会带来这样的威胁。

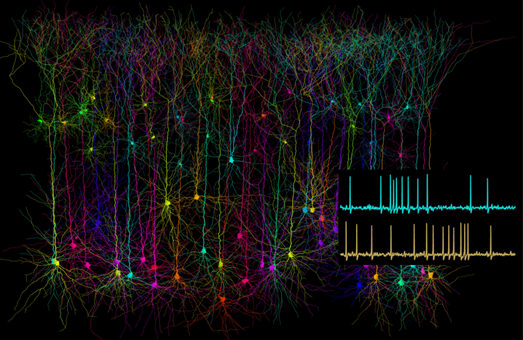

导致深度学习的功能局限、阻碍深度学习在功能上逼近大脑的核心原因,在很大程度上是由于目前深度学习技术中的神经元模型和突触模型还没有突破传统模型的限制。在自然界中的真实大脑的神经信号都具有Spike这一特征;而传统神经元模型则把Spike简化为频率,丢弃了时域中一些快速变化的信息。在学习方面,大脑中的突触具有复杂多变、非线性动力特征的可塑性,而在深度学习中还仅仅是些权重参数,不具有动态特征。虽然有一种观点认为,也许Spike只是鸟的羽毛,我们不需要羽毛也能造出飞机,但飞机在空中的生存技能还远远不如鸟类。不具有动态特征和精细的时域信息的神经网络,可以运算的更快,但一定在功能上会有缺陷(当然这也取决于具体的应用)。

(三)仿脑计算的优势、可行性及其前瞻

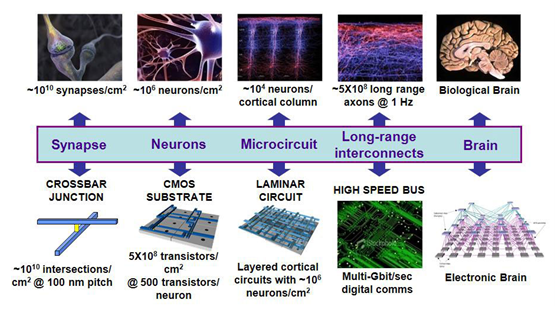

怎样能使神经网络模型更加精细和具有动态特征呢?仿脑计算在这方面表现出巨大的优势。仿脑计算则不但要从结构上模仿大脑,而且还要从神经元和突触的模型上模仿大脑,所以某种意义上讲,仿脑计算也可看成是深度学习将来的发展方向。由于需要从神经元和突触这样的微观模型上模仿出宏观的大脑功能,仿脑计算面临着诸多的挑战。有人甚至认为仿脑计算还很遥远。真的是如此遥远而不可及吗?我们先来看看这些挑战以及可能的解决方案。

神经元的信号是指细胞内外的电压差。它主要来自众多突触受体的电流变化以及自身离子通道的特性。早在1960左右的HH方程已经相当精确地描述了神经信号的发生机理。因此,理论上讲,HH方程就是神经元最精确的模型。但是,HH方程是一套非线性动力学方程,没有数学上的解析解,只能采用数值计算方法,一步一步地以逼近的方式进行推演计算。为了确保逼近的精确度,每一步步长都非常短(例如0.01毫秒)。所以对于现在的计算机而言,一个十万或百万个神经元的神经网络的计算是个十分沉重的负担。因此,如何能快速计算HH方程或者修改HH方程达到快速计算的目的成为了一个重要的研究方向。LIF模型是一类对HH模型的简化模型。由于LIF模型起码保持了Spike的特征,受到许多研究团队的认可。目前,美国和欧盟的脑计划中的硬件类脑计算模型就是基于LIF模型,期望达到大规模、低能耗的类脑功能。可以证明的是,对LIF模型的进一步简化可以形成传统的人工神经元模型。因此,不管如何,基于Spike的神经网络(也称SNN)应该会比深度学习基于的传统人工神经网络(ANN)展示出更优良的性能。

突触是信号传递以及使大脑具有学习功能的主要微观结构。突触在大脑里的数量比神经元还要高出1000倍左右。突触不但数量大,而且模型十分复杂。虽然可以分成兴奋和抑制两大类型,但由于不同的神经递质受体的差异,它们的特征各有千秋。在深度学习中,用一个简单的权重参数来描述突触的性能,实在是对那么多蛋白质功能的极大藐视。如果大脑的突触只有一种蛋白质的话,相信一定早就被自然界淘汰了。所以,绝大部分脑科学家不会认为深度学习会给脑科学带来多大贡献。但是,仿脑计算则采用比权重参数更复杂的突触模型,尽量逼近真实的突触模型。例如,采用简单但与时间相关的STDP模型,人们已经可以模拟出类似于狗的条件反射实验,这代表了动物的联想式的学习功能。所以科学家们对仿脑计算有更高的期盼。

虽然自HH方程的提出,就有仿脑计算的想法,但真正尝试百万个神经元的大规模仿脑神经网络的计算还是近些年的事。从目前公开报道的情况看,还没有任何一个研究团队成功实现类人的人工智能。这可能有多种原因:1,采用的模型也许还过于简单;2,其中的某个模型过于简单而引起的短板效应;3,大脑还有更多的秘密。从目前的情况看1和2的可能性很大。许多研究团队都希望用最简单有效的方法模拟出大脑的功能。如果失败,再增加复杂性,提高仿真度,逐步向真实的大脑逼近。至今为止,虽然仿脑计算还没有实现类人的人工智能,但很多人相信这只是时间问题。核心原因是:人脑是可以模仿的,而且可行性越来越大。采用现代GPU技术我们已经可以实现百万级神经元的仿脑神经网络的计算。伴随忆租器技术的进一步发展,将来有望直接实现高仿真神经网络的硬件系统。因此,仿脑计算也并非十分遥远,而且已经成为了国际科研领域的热点。

在我国,由于长期以来,从事计算机研究的和从事脑科学研究的学者属于两个群体,甚至从基础学科开始就有较大分歧,计算机研究人员常常是数理类学科出身,而脑科学研究者常常是生化医学类教育背景,所以从事仿脑计算研究的人还很少。在国外,由于脑科学起步较早,与之相关的交叉学科近年来得到迅速发展。计算神经学(Computational Neuroscience)已经成为一门重要的交叉学科,仿脑计算也成为计算神经学的核心目标。

仿脑计算不但可以作为深度学习未来发展的方向,而且还将引领计算技术的革命。目前,计算机还面临许多难题,离类人脑的人工智能水平还差得很远。很多人脑能轻松搞定的事情,计算机还无能为力。现在的深度学习只是解决了一些和感知相关的识别问题,和大脑的整体功能相比还相差甚远。从本质上看,现代计算机是具有处理器与储存器分离特征的冯诺依曼结构计算机,而大脑对信号的处理与储存不完全分离,甚至在很大的程度上是分不开的。目前计算机面临的许多难题都与冯诺依曼结构相关(也称冯诺依曼瓶颈),而仿脑计算的研究有望突破冯诺依曼瓶颈,实现新一代非冯计算机。

深度学习方兴未艾,仿脑技术悄然崛起。类人的新人工智能即将到来也并非危言耸听。早做准备才不至于坐以待毙。如果能率先掌握并把控好这一人类历史上即将出现的重大技术,则将是对全民族和全人类的最大福报。伴随我国脑计划即将拉开序幕,我们有理由相信,我国的仿脑计算也将成为新的亮点。

作者介绍:

曹立宏,中国传媒大学脑科学与智能媒体研究院院长,教授,博士生导师;北京市协同创新研究院智能传媒技术中心主任。美国国家卫生总署(NIH)博士后。北京市首批“脑科学研究”专项指导组受聘专家。