近年来,以深度神经网络为代表的人工智能技术发展迅猛,在多个领域达到接近甚至赶超人类的水平。除了AlphaGo在围棋人机大战中打败多名世界级高手之外,AI在诸多人机大战中都有着不错的表现。近日,中国传媒大学脑科学与智能媒体研究院自主研发的“人工智能内镜下精准识别辅助诊断系统”就在人机读片交流竞技中以“0.2秒/张的病变识别速度、接近90%的识别正确率”表现不俗。尤其在胃恶性肿瘤图片判读中,AI的正确率更是超过了在场92%的消化内镜医师。

对于人类而言,我们睁着眼睛的每时每刻几乎都在做着视觉搜索的任务,从桌子上找到手机、从书中找到某一段话、或者是从茫茫人海中找到TA。因此,视觉搜索任务在生活中十分重要,具备视觉搜索能力的AI也将在自动驾驶、计算机辅助诊断等领域发挥重要的作用。然而,你有没有想过这样一个问题,如果生活中的某个物品放大了3倍,你和AI搜索它的能力是否会改变呢?

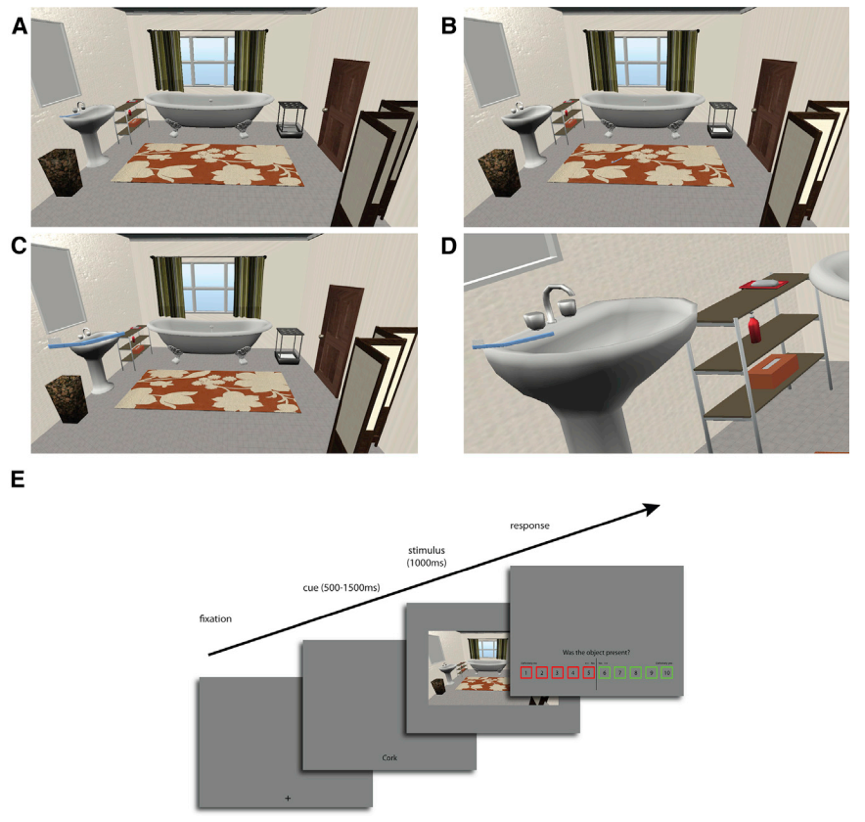

为了研究这个有趣的问题,来自美国和土耳其的科学家设计了一组实验,实验中给人类受试者和AI在一个场景中呈现正常尺寸的物品以及放大了3倍到4倍的物品(如在盥洗室中呈现牙刷),图片呈现1秒钟的时间,人类和AI需要指出该场景中是否有目标物体。

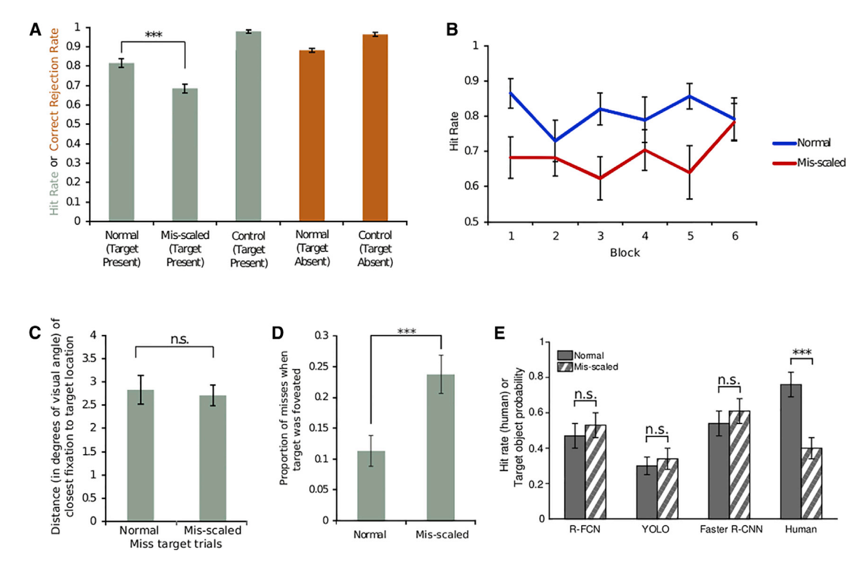

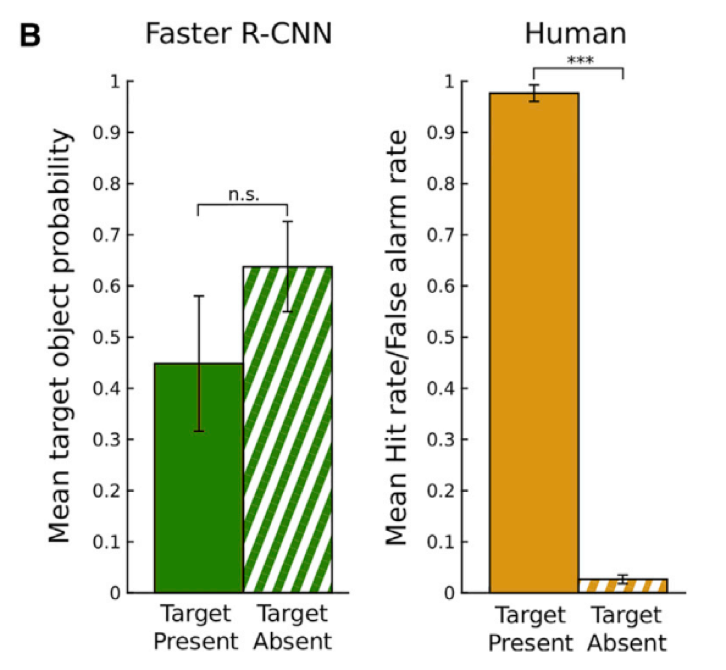

通过统计人类和AI的正确率,科学家发现,如果物体的尺寸变大,人类搜索到它的概率显著地低于正常尺寸的情况。而AI的识别准确率在正常尺寸和放大尺寸两种情况中并没有显著差异。

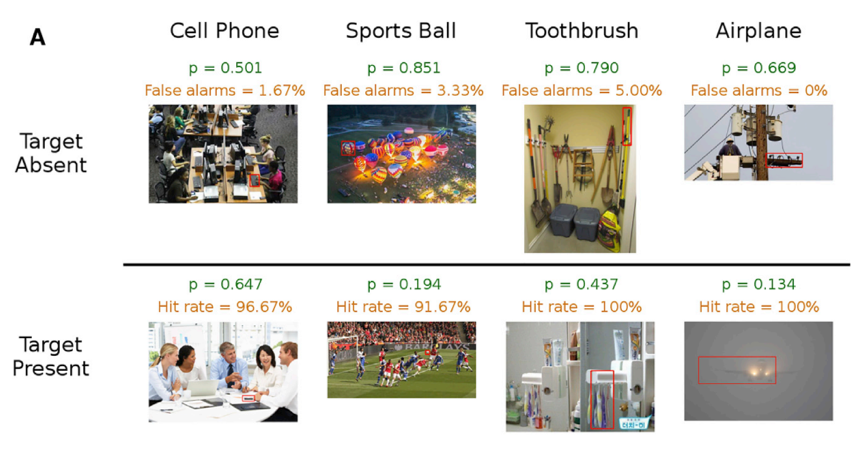

进一步,科学家给人类和AI呈现一组图片,并告知其目标物体(如手机),图片中可能有目标物体,也可能没有目标物体。如果AI认为图片中有目标物体,则会用红框把目标物体框出来。

在这项视觉搜索任务中,人类完胜AI。举个例子,AI在一幅人使用键盘的场景图片中把键盘标记为目标物体:手机。而对于我们人类而言,我们很清楚的知道键盘和人之间的尺寸比例是远大于手机和人之间的尺寸比例的,所以,我们不会把搜索目标定在键盘这种尺寸的物体上,更不会把键盘误认为手机。而AI对物体的尺寸是没有概念的,仅仅是通过物体的特征做出判断而忽略目标物体跟周围物体之间的关系,其判断准确率必然会大幅降低。

总之,人类对于尺寸异常的物体判断准确度降低,这很可能是大脑在视觉搜索中的一种高效判断策略,就好比我们要找手机,一定是按照手机的尺寸去有针对性的寻找,而不会忽视掉尺寸的信息盲目的寻找。人类的此项优势正式目前AI的劣势,目前的深度神经网络仅仅简单的借鉴了人脑的视觉加工流程(从视网膜到V1,V2,V4和IT),其神经元模型、网络连接方式及权重更迭过程均与人脑有着很大的差异。另外,视觉系统与前额叶、海马系统等高级认知中枢都有着双向连接,这使得人类可以在视觉搜索任务中加入注意机制,从而提高搜索效率。

参考文献:

Eckstein et al., Humans, but Not Deep Neural Networks, Often Miss Giant Targets in Scenes, Current Biology (2017)

本文为原创编译,转载请注明出处