大脑活动的解码一直是科学家们的研究热点,想想看,如果通过测量和分析大脑活动就能知道你的所知所想,我们就进入“读心术”时代了。当然,“解码”总是带有一些神秘色彩的。我们看到的图片,听到的声音,怎么就变成了一串串的动作电位序列?如果我们测到了这一串串动作电位序列,又能否解码出大脑的输入?所以说,解码这件事情并不简单。尽管不简单,科学家们还是体现出了迎难而上的宝贵科学精神,尝试了各种解码大脑活动的方法。就在几天前,来自美国普渡大学的科研团队就采用受脑启发的神经网络成功解码人们在观看视频时的大脑活动。下面,我就为大家一一揭秘“解码”大脑活动的过程。

如果让我选择解码大脑视觉活动的方法,深度学习一定不失为一个好的选择。为什么呢?因为卷积神经网络(CNN)受到大脑视觉系统的网络结构和功能的极大启发。做个类比,CNN的输入与视网膜的输入类似,不断加深的卷积层类似于外侧膝状体(LGN)到初级视觉皮层(V1),再到V2/3、V4的过程,CNN的输出则与负责物体识别的颞下皮层(IT)十分类似。既然如此,我们能不能把不同脑区的活动和CNN中不同层的输出做个映射,然后由大脑活动反推出当前时刻的视频内容呢?

科学家们通过实验和分析告诉你:当然可以。

通过给受试者和采用AlexNet架构的CNN看视频,同时用fMRI测量受试者的大脑活动,科学家们得到了受试者的大脑活动时间序列和CNN中每一层的时间序列。数据分析结果表明,CNN中不同层的时间序列与受试者的不同脑区的大脑活动时间序列有着很高的相关性。其中,CNN中比较靠前的层与视觉通路中低级的皮层(V1)活动有很高的相关性,而CNN中比较靠后的层与视觉通路中高级的皮层(IT)活动有很高的相关性。

而且,大脑中负责人脸识别的FFA(fusiform face area)脑区的活动与CNN最后一层用于表征“脸”的神经元的活动之间的相关性相当的高。

同时,大脑中用于表征动物、汽车等物体的脑区与CNN中最后一层用于表征这些类别的神经元活动也有较高的相关性。

通过解码不同脑区的活动,可以估计出CNN中第一层和第七层的输出。

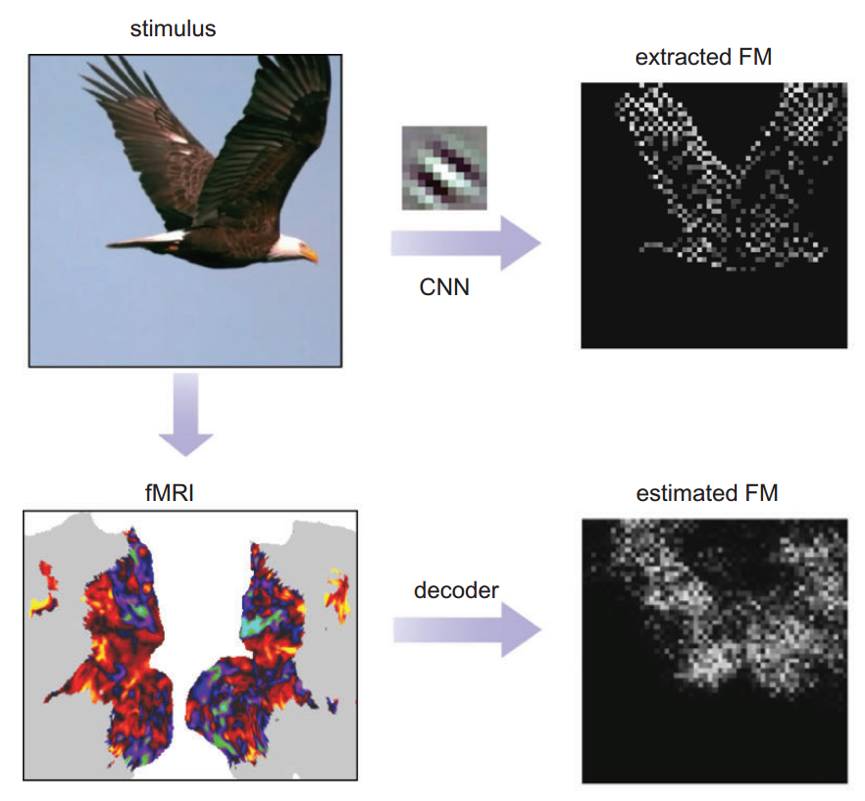

下面就是估计出的第一层特征图,虽然模糊了些,但与CNN的真实特征图还是很相似的。

有了CNN第一层的特征图,就可以根据反卷积的方式重建出所见的视频内容了。

下面是根据不同区域大脑皮层的活动估计的CNN第七层输出而得到的视频内容的分类结果。

这个解码的过程告诉我们,用脑启发的智能解码大脑是可行的,且CNN对视觉信息的处理流程与大脑的视觉加工过程之间存在稳定的映射关系。

参考文献:

Haiguang Wen, Junxing Shi, Yizhen Zhang, Kun-Han Lu, Jiayue Cao, Zhongming Liu. Neural Encoding and Decoding with Deep Learning for Dynamic Natural Vision. Cerebral Cortex, 2017; 1 DOI: 10.1093/cercor/bhx268

本文为原创编译,转载请注明出处