作者 | 刘定坤

审校 | 洪 波

编辑 | 杨小姣

内容来源:公众号BrainQuake大脑激荡 授权转载

2020年10月19日,美国国家医学科学院(NAM)宣布增选100位院士,其中有90名常规院士和10名外籍院士。入选该学院被认为是健康和医学领域的最高荣誉之一,并表彰表现出杰出的专业成就和对服务的承诺的个人。其中,著名的神经科学家Edward Chang教授入选。

Edward Chang

Edward Chang,加州大学旧金山医学中心。为破解人脑皮质中语音的功能蓝图,率先开发出先进的人脑图谱临床方法,并率先为瘫痪的患者提供新型的转化神经修复技术。

下面,一起回顾该小组近年来的系列研究!

近日,加州大学旧金山分校神经外科Edward Chang教授研究组,结合深度学习方法把病人颅内的脑电信号翻译成了语音,论文发表于Nature子刊《Nature Neuroscience》,引起了广泛关注。媒体的解读让人们产生非常热切的期待,似乎普通人戴上一个脑电“魔法帽”,就可以读出自己心里想说的话。有了这种脑机接口新技术,未来我们不用打字,也不用张口说话,就可以把要说的话送进手机,直接微信聊天。这样的场景真的能实现吗?这样的未来离我们有多远?本文将回顾该小组近年来的系列研究,带你深度解读这项技术背后的科学和工程挑战。

图1 加州大学旧金山分校神经外科Edward Chang教授

Edward Chang教授研究组是利用癫痫病人手术前定位癫痫病灶的机会,在病人语音处理相关的脑区植入数百个微电极,记录到的大脑内神经电活动,训练了一个可以将大脑内神经电活动端到端(Seq-to-Seq)转译成文字的深度循环神经网络模型。这项研究报告,四位病人颅内脑电解读错误率最低可以达到3%(WER,一种用编辑距离来定义的错误率)。因为电极植入位置和病人个体差异,最坏的情况错误率在50%左右。语音脑机接口的一个核心难题是神经信息的解码和翻译,脑电信号噪声大,人脑编码语音语言的机制复杂未知,这都是背后的障碍。这项研究引入了机器语言翻译中常用的循环神经网络LSTM,为脑机接口打开了一条应对这一挑战的新路径。端到端的网络架构虽然不能给出可解释的规律,但从工程上来说是有效的。我们很高兴地看到,脑科学和人工智能技术的结合,正在加速语音脑机接口的探索和研发的进程。

在此之前,Edward Chang课题组于2019年4月在Nature杂志发表了题为Speech synthesis from neural decoding of spoken sentences的文章(Anumanchipalli et al., 2019),实现了基于颅内微电极采集得到的神经电活动进行的语音合成,由病人颅内脑电翻译合成的语音达到了人类听众能够有效识别的水平。

随后的2019年7月在Nature Communications上发表了题为Real-time decoding of question-and-answer speech dialogue using human cortical activity的文章(Moses et al., 2019),在同样的实验系统上展示了基于脑电翻译的问答系统,对问题和回答的判断准确率分别达到61%和76%,随机水平分别为7%和20%。

事实上,Edward Chang课题组借助癫痫病人手术的机会,对人脑语音处理的系统已经进行了近十年的研究。这些研究详细了解了大脑对于声音的编码机制(Mesgarani et al., 2014)和大脑对于发声器官的控制规律(Chartier et al., 2018),这些研究为如今这三篇语音解码的工作奠定了坚实的生理基础。

这三篇语音解码的工作针对的是脑电语言解码中三种不同类型的任务。

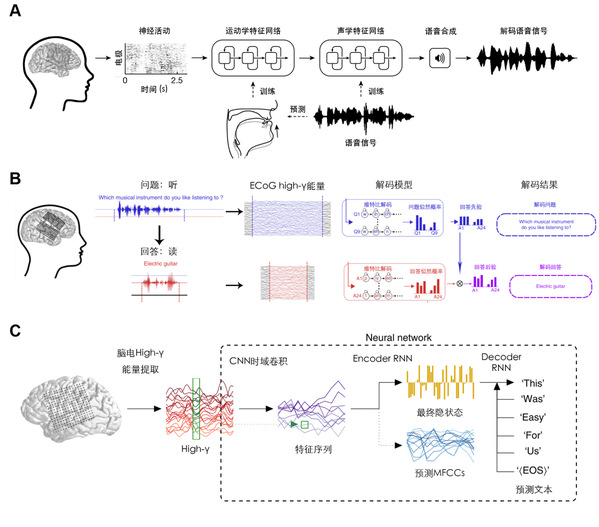

Edward Chang课题组于2019年4月份发表在Nature上的工作(Anumanchipalli et al., 2019),目的是利用颅内脑电活动翻译生成语音。这个工作利用256通道的高密度颅内皮层电极记录受试在朗读句子时候的大脑电活动,同时利用一个在MOCHA-TIMIT数据集上预训练好的神经网络通过声音信息预测发声器官的运动轨迹(Chartier et al., 2018)。作者使用两层双向LSTM网络,第一层网络将神经活动解码为发声器官(包括喉、舌、嘴唇和下颌)的运动轨迹,第二层网络将运动学特征解码为声学特征,文中使用的是梅尔倒谱系数(Mel-frequency Cepstral Coefficients, MFCCs),最终将梅尔倒谱系数转化成语音(图2A)。

图2. 颅内脑电解语音。A.通过脑电合成语音;B. 通过脑电实现问答系统; C. 通过脑电转录说话时的文本

他们在2019年7月份发表的工作(Moses et al., 2019),目的是利用脑电活动实现一个问答系统。这里同样使用高密度皮层电极,记录了大脑在听问题和回答问题时候的颅内脑电活动,解码模型首先利用听问题时的脑电活动选择出最有可能的问题,进而确定不同的回答的先验概率,在受试回答问题的时候,模型给出受试的不同的回答的似然,结合之前的先验,确定最有可能的回答。可以看到,本质上这是个分类问题(图2B)。

2020年3月最新发表的工作(Makin et al., 2020),这个工作利用机器翻译模型,将脑电转录为以句子为基本单元的连续文字。这里通过高密度皮层脑电图记录大脑的高频电活动,通过CNN网络时域卷积提取特征,然后利用一个Encoder-Decoder模型,将阅读句子时的脑电特征转录为文本。需要注意的是,这个Encoder-Decoder模型在训练时会在Encoder阶段同时进行梅尔倒谱系数系数的多任务训练,利用这个多任务共同训练能够增加额外的信息,从而提高最终模型的性能(图2C)。

机器学习模型

脑机接口中的神经解码离不开机器学习工具的支撑。这三篇研究中,有两篇利用了深度神经网络,一篇则主要利用的是传统的自然语言处理算法。

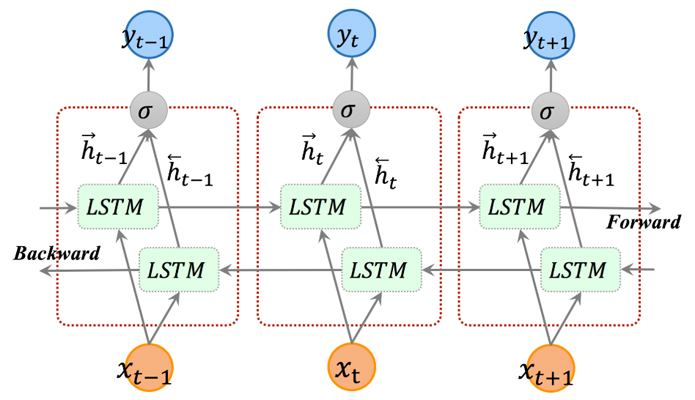

图3. 颅内脑电合成语音的工作采用了双向LSTM模型

第一篇语音合成的工作采用的是一个两层的双向LSTM结构(图3)。每一层都包含两个平行的LSTM层,分别接受正序和倒序的输入内容。第一层将脑电解码为发声器官的运动轨迹(Chartier et al., 2018),第二层将发声器官的运动轨迹解码为梅尔倒谱系数。最终,将模型输出的梅尔倒谱系数重新合成成音频,得到语音的合成。这项研究中用到的语音材料主要是MOCHA-TIMIT数据集,这个数据集包含460个句子。此外,部分受试也朗读了一些图片描述的材料和一些自由组织的语句。

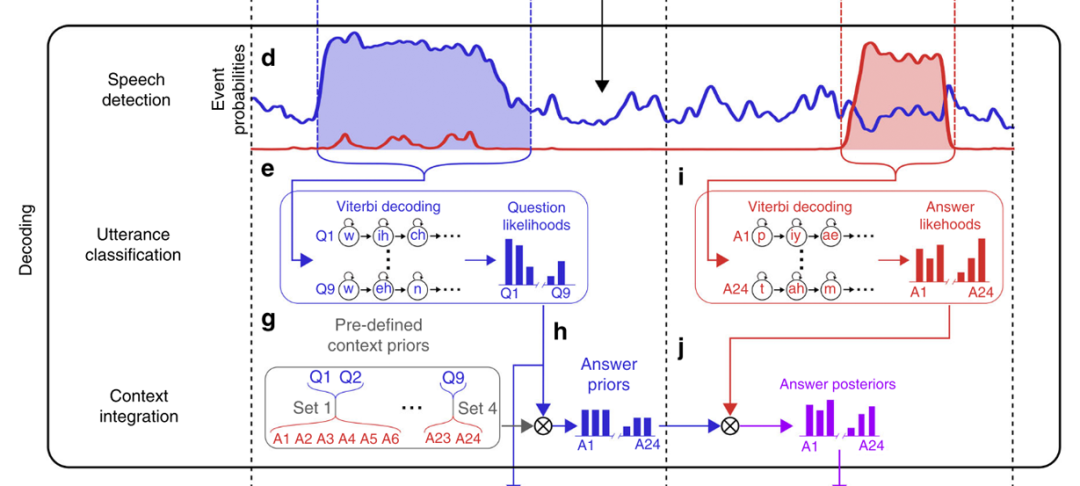

图4. 颅内脑电翻译问答系统采用了经典的语音识别维特比解码算法

第二个问答系统的工作基于的是传统的计算机语音识别模型(图4)。方法包含三个部分,第一个部分是语音检测模型,这个模型本质是一个线性判别分析(Linear Discriminant Analysis, LDA)分类模型,利用对不同语音状态有显著响应的脑电通道的high-γ(脑电中的高频能量)信息,来判断使用者的状态是听/说/安静三者中的哪一个。第二个部分是话语分类模型,这是一个隐马尔科夫模型,隐状态是当前语音的音素,而观测状态则是脑电时频特征。这个模型通过脑电时频特征序列,解码最大似然的问题/回答音素序列,从而找到不同问题/回答的似然概率,对于问题,选择最大似然的问题作为问答系统的解码结果。对于回答,还存在第三个贝叶斯概率模型,结合对问题的先验判断,计算不同回答的后验概率,选择后验概率最大的回答作为决策。这项研究的问答数据集包含9个简单问题和与之对应的24个回答,是一个相对简单的数据集。

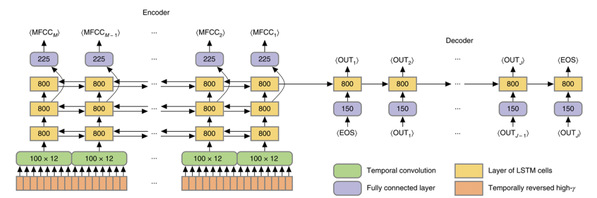

图5. Encoder-Decoder脑电转录文本神经网络模型

第三个脑电转录文本的模型采用Encoder-Decoder组成的神经网络(图5),编码器Encoder部分将脑电高频能量信息利用卷积网络提取特征,然后利用多层LSTM压缩为一个状态向量,与此同时,Encoder会在训练时估计语音的梅尔倒谱系数作为多任务共同训练;第二部分解码器Decoder将前一部分得到的状态向量利用LSTM层解码为对应文本。这项研究主要使用的是MOCHA-TIMIT数据集的子集,使用了其中50个句子(大约包含250个不同的单词)给受试重复多次朗读。任务在数次重复朗读的材料上训练,在一次不同的重复上进行测试。

这三个工作的模型都极大地受到了计算机语音识别和自然语言处理技术发展的影响,尤其近期深度学习在自然语言处理中的广泛应用,也使得神经语言解码有了新的更加强大的工具。

语音神经编码机制

即使有了强大的机器学习和人工智能工具,要推动神经语言解码的实质性发展,还必须依靠我们对大脑语音编码规律更加深刻的理解上。上面三项工作成功的背后离不开神经生理机制的发现。

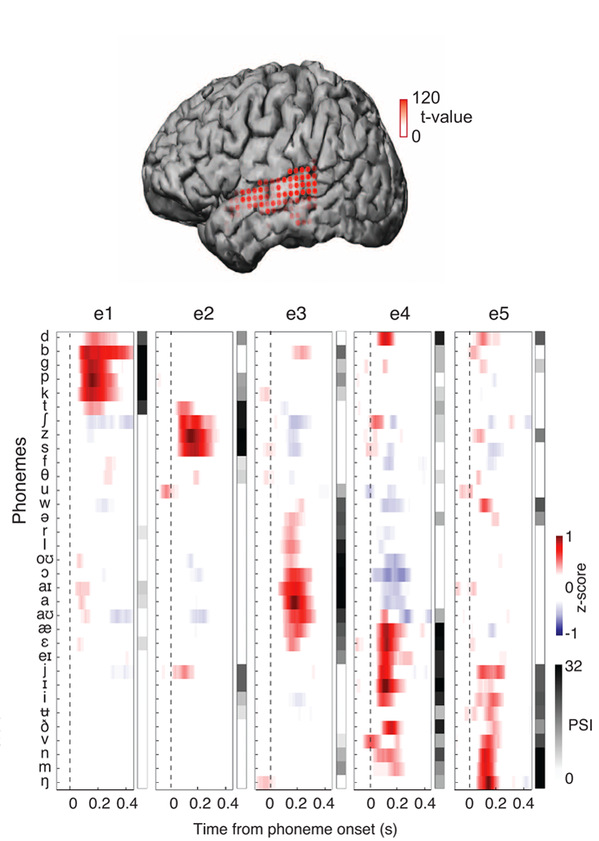

2014年Edward Chang课题组研究揭示了人脑颞叶的颞上回(Superior Temporal Gyrus, STG)对语音的语音学特征的编码规律(Mesgarani et al., 2014)。研究发现,在大脑的不同位置的电极记录到的信号,表现出了对不同语音学特征的选择性(图6)。并且,这种选择性来自于对于语音时频域特征的分布式群体编码。换句话说,大脑通过分析语音的时频域特征可以通过有选择性的群体编码将其提取为离散的语音学基本单元—音素(Phoneme)。简单讲,我们的语音中a,o,e, b,p,m这些基本的单元在人脑中由不同群体的神经细胞来分工处理,在颞叶脑区形成一个有规律的功能图谱。

图6. 人脑颞叶皮层不同电极对于语音基本单元的编码

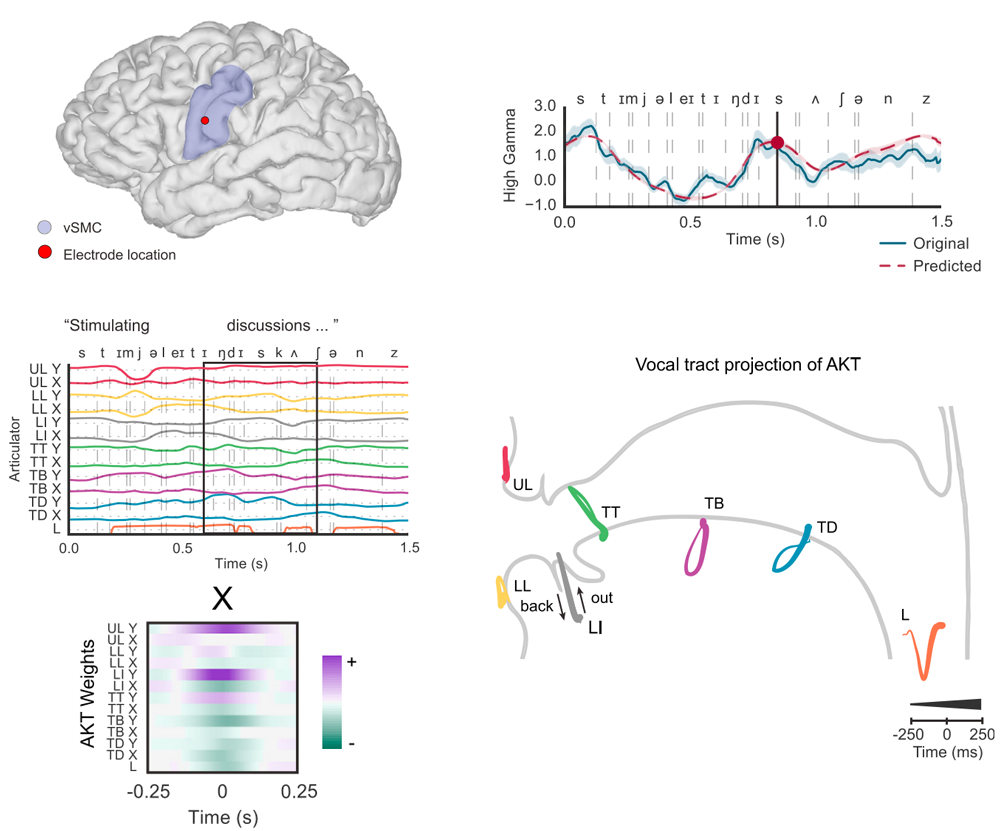

在2018年,他们进一步研究了人在发声过程中大脑运动的处理机制(Chartier et al., 2018)。作者发现外侧的感觉运动皮层(Speech Motor Cortex, SMC) 负责编码发声过程中喉、舌头、嘴唇和下颌这些发声器官的运动轨迹,通过感觉运动皮层上电极记录到的高频颅内脑电信号,可以翻译还原出各个发声器官的运动轨迹(图7)。

图7. 外侧感觉运动皮层上的电极对于发声器官运动轨迹的编码

基于这两方面的研究,Edward Chang课题组针对性地对人在说话过程中听与说的响应特性构建了语音解码模型,模型能够针对性地利用听觉系统的神经信号解码音素(Anumanchipalli et al., 2019; Moses et al., 2019)或者声学特征(Makin et al., 2020),同时利用感觉运动皮层对于发声器官的控制模式,还原发声过程或者还原声音信息本身(Anumanchipalli et al., 2019; Makin et al., 2020)。简单讲,听觉脑区和感觉运动脑区都包含语音编码相关的神经活动,最佳的策略是同时有电极覆盖到这两个区域,脑机接口解码的准确率才会提高。错误率最低3%的病人就是这种情况。

神经电极配置

除了神经编码机理和机器学习解码方法,语音脑机接口的另一个重要环节是“接口”的部分,也就是用来采集脑电信号的电极。

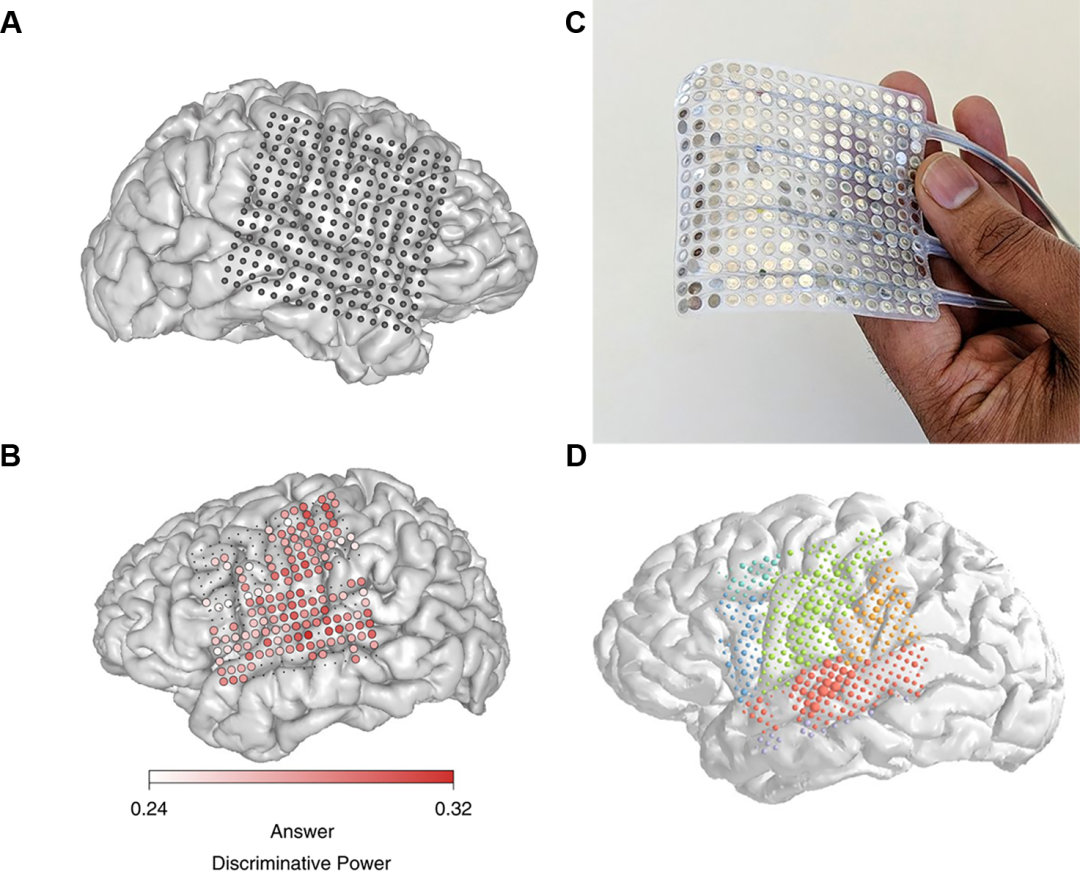

在这三项研究中,使用到的都是如图4所示的高密度的颅内皮层电极(micro ECoG)。这个电极由16*16共计256个间距为4mm的触点组成(图4C)。这种电极被用来给患有疑难癫痫的病人临时植入定位癫痫灶,因此它不能长期保留在人脑中,一般是1-2周时间。在这三项研究中,电极主要覆盖了人脑的外侧裂周区(peri-Sylvian)(图4),对语音解码任务最重要的贡献来自控制发声器官的腹侧感觉运动皮层(Ventral Sensorimotor Cortex, vSMC)和控制听觉感知和反馈的颞上回(Superior Temporal Gyrus, STG)(图4D)。要植入这样一大片电极,手术创伤显然是很大的,目前只能是在癫痫病人手术前的电生理评估中,用于正常人是不可想象的。

图8. 256通道高密度ECoG电极及其植入位置示意

魔法帽还在路上

Edward Chang研究组近期在自然语音材料的高效解码上所取得的突破令人瞩目,背后是过去10年神经科学领域对于语音在人脑中的编码规律认识越来越清晰。除了美国UCSF、Johns Hopkins等大学研究团队的工作,笔者所在的清华大学神经工程课题组也揭示了语音声调的神经解码机制(Si et al., 2017)。一方面,相比之前利用大脑响应信息进行语音解码的工作,Edward Chang研究组的工作大量使用端到端训练的神经网络模型,这在利用到现阶段人们对于大脑语音解码和发声控制的神经编码规律的同时,充分利用了数据驱动的机器学习方法的能力,极大地简化了特征提取的流程。另一方面,由于脑电信噪比较低,很难直接基于连续语音材料的解码,所以他们在模型中利用到了上下文语音语义信息的补充,这在很大程度上能弥补脑电中无法还原出的信息。人工智能技术和脑机接口的结合,当然也带来了新难题:如何获得大量的训练数据?来自人脑的高精度神经数据通常只在临床条件下能够获得,普通的头皮脑电又过于嘈杂,所包含的相关信息太少,网络训练会陷入不收敛的困境。

必须承认,今天我们还没法送给大家一顶脑电“魔法帽”,利用脑电的语音解码走向实用仍然存在相当多的科学与工程的挑战。一方面,这三项工作目前利用的都是大声朗读情况下的脑电,所以解码过程能够同时利用发声过程和听觉反馈过程的信息。但未来实际的脑电语音解码应用场景是,不发声默说的情况下能够解码,这种条件下的神经编码和大声朗读条件下还有很大不同,其间的距离该如何填补仍是一个开放的问题。另一方面,目前的研究中使用的都是高密度ECoG阵列,这种电极对大脑皮层表面有明显压迫,长期安全性无法保证,仅被批准短期内植入进行癫痫灶定位。未来真正具有实际应用价值的植入电极需要具有微创性和长期安全性。一个可行的方案是在大脑的硬脑膜上植入微型电极阵列,由于这种电极不破坏硬脑膜(Dura matter),因此能够长期稳定放置,且不会引发大脑的炎症反应(Zhang et al., 2013; Benabid et al., 2019; Sauter et al., 2019)。

当然,最理想的“魔法帽”是人人都可以拥有,不用做手术,戴上就可以翻译合成你要说的话。这是一个非常诱人的挑战,我们和材料科学、微电子以及人工智能的团队正在合作攻关,“魔法帽”的未来可期。

参考文献